Première réglementation de l’UE dédiée à l’intelligence artificielle, l’AI Act vise à encadrer le développement, la mise sur le marché et l’utilisation des systèmes d’IA (SIA) pouvant présenter des risques pour la santé, la sécurité ou encore les droits fondamentaux des citoyens européens.

Selon le texte officiel de l’AI Act, le terme “système d’IA” désigne :

(...) un système automatisé conçu pour fonctionner à différents niveaux d'autonomie, qui peut faire preuve d'une capacité d'adaptation après son déploiement et qui, pour des objectifs explicites ou implicites, déduit, à partir des données d'entrée qu'il reçoit, la manière de générer des résultats tels que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer les environnements physiques ou virtuels.

Le terme englobe donc des applications déjà ancrées dans la vie quotidienne de nombre de citoyens européens, comme les assistants virtuels ou les recommandations générées par les plateformes de streaming.

Le calendrier d’application de l’AI Act est progressif, et le 2 août marque une échéance majeure, avec l’entrée en vigueur des premières obligations concrètes pour l’écosystème IA.

Les fournisseurs de modèles d’IA à usage général (GPAI – General Purpose AI) devront :

En parallèle, les autorités de surveillance prennent fonction :

Enfin, le régime de sanctions financières est activé :

Ces règles s’appliquent à toute entreprise dont les systèmes d’IA sont proposés ou utilisés dans l’Union, appliquant le même principe d’extraterritorialité que le RGPD.

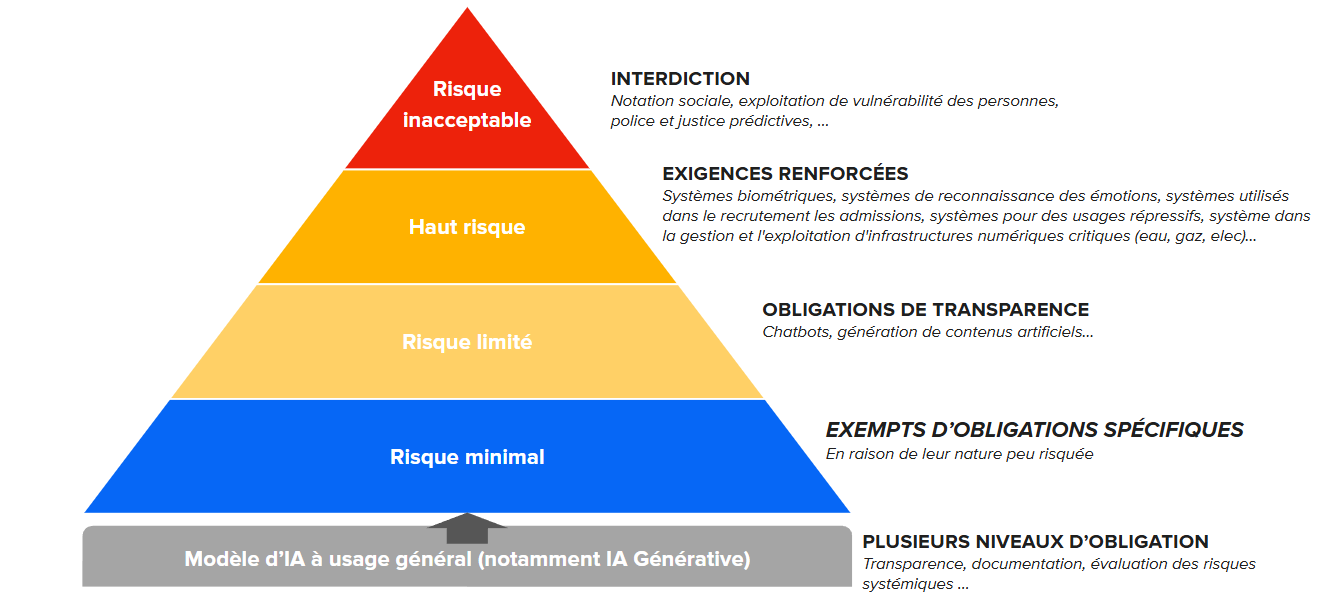

Le principe central de l’AI Act repose sur une classification des systèmes d’IA en quatre niveaux de risque, chacun impliquant des obligations spécifiques :

Notez que les obligations liées aux systèmes à haut risque ne seront pas effectives au 2 août 2025, mais entreront en vigueur courant 2026. Il reste donc crucial de s’y préparer dès maintenant.

Dans le cadre de l’AI Act, la distinction entre les rôles de « fournisseur » et de « déployeur » devient centrale.

Le fournisseur est celui qui développe ou fait développer un système d’IA, ou qui le met sur le marché sous sa propre marque, que ce soit à titre gratuit ou payant. Sa responsabilité première est de garantir la conformité du système avec les exigences de sécurité, de fiabilité et de respect des droits fondamentaux définies par le règlement.

Cela implique la production d’une documentation technique rigoureuse, la transparence sur les données utilisées, et la communication d’instructions claires pour une utilisation sûre de la technologie. Pour les modèles d’IA à usage général, le fournisseur doit également publier un résumé des données d’entraînement et démontrer le respect des règles de propriété intellectuelle.

Le déployeur est l’entité qui utilise un système d’IA sous son autorité, hors usage strictement personnel. Le déployeur doit mettre en œuvre le système conformément aux recommandations du fournisseur et en veillant à la protection des droits des utilisateurs finaux. Il doit s’assurer de la compétence de son personnel pour garantir une utilisation responsable et sécurisée de l’IA, surveiller le fonctionnement du système et signaler tout incident ou risque potentiel. Le déployeur est également tenu de collaborer lors des audits ou contrôles réglementaires en fournissant toutes les informations nécessaires.

Lorsqu’un système d’IA est classé « à haut risque », les obligations se renforcent pour les deux parties. Fournisseurs et déployeurs doivent alors mettre en place des procédures de gestion des risques, documenter précisément le fonctionnement et les usages du système, et assurer une transparence accrue vis-à-vis des utilisateurs et des autorités de contrôle.

Si le 2 août 2025 marque un tournant réglementaire pour toutes les organisations impliquées dans le développement ou l’exploitation de l’IA, il ne s’agit que d’une première étape. Le calendrier de l’AI act est voué à s’étendre jusqu’en 2026-2027, avec des obligations croissantes.

Concernant cette réglementation, la mise en conformité ne s’improvise pas : elle suppose de structurer sa gouvernance IA, de documenter ses modèles, et d’assurer la transparence vis-à-vis des utilisateurs comme des régulateurs. Contactez-nous pour découvrir comment fifty-five peut vous aider à vous adapter à l’AI Act et appliquer l’IA de façon raisonnée, innovante et sécurisée.

Discover all the latest news, articles, webinar replays and fifty-five events in our monthly newsletter, Tea O'Clock.